오픈소스 LLM Top 5 (2024)

2023/01/12 | 3 minsLLM 2023년 월별 핫뉴스 총정리 리포트를 받아보세요!

이것만은 꼭 알고 가야하는 LLM 소식과 2024년 미래 동향을 한 번에 정리해드립니다.

오픈소스 LLM의 장점

생성 AI에 대한 관심이 늘어나면서 인공지능 시장의 판도는 다양한 오픈소스의 등장과 함께 변화하고 있습니다. 올해 출시가 예정된 프론티어 대형언어모델(LLM)만 10여개가 넘는 것으로 나타났는데요. 오픈소스 LLM은 접근성, 투명성, 비용 효율성 등의 장점으로 주목받고 있습니다. 이러한 특성으로 인해 기업은 니즈에 따라 맞춤화하여 사용할 수 있으며, 파인튜닝을 통해 엄청난 양의 데이터 학습이나 자체 시스템 개발 없이도 새로운 모델을 빠르게 개발할 수 있습니다. 이러한 강점 덕분에 AI 기술을 발전시키기 위해서는 건강한 오픈소스 생태계를 키워나가야 한다는 업계의 목소리도 커지고 있는데요. 아래에서 오픈소스 LLM의 장점을 좀 더 자세히 살펴봅시다.

- 빠르고 유연한 개발 환경

: 커뮤니티를 통해 여러 사람들이 동일한 프로젝트에 기여하면서 아이디어를 교환하고 문제를 해결할 수 있는 환경이 조성되어 버그 수정이나 기술적인 문제를 개선하는 작업이 빠르게 이루어질 수 있습니다. 이는 유지 보수 측면에서도 효과적입니다.

- 높은 접근성 및 확장성

: 사용자의 필요에 따라 코드를 수정하거나 확장하여 프로젝트의 목적에 맞게 커스터마이징 할 수 있습니다.

- 투명성을 바탕으로 교육 및 연구 기회 제공

: 오픈소스 LLM의 투명성은 관련 연구를 촉진하며, 학생 및 연구자들에게 교육적인 자원으로 활용됩니다.

- 비용 절감

: 자체 시스템 개발 없이도 무료로 사용할 수 있는 오픈소스 소프트웨어를 활용하면 비용과 시간을 절감할 수 있으며, 스타트업과 기업이 새로운 제품과 서비스를 개발하는데 자본에 대한 부담을 덜 수 있습니다.

LLM 모델 도입 추이 (출처: A Comprehensive Overview of Large Language Models)

본격적인 오픈소스 LLM 열풍은 2023년 2월에 메타가 LLaMa를 학계에 공개하면서 시작되었습니다. 이를 계기로 LLaMa를 기반으로 한 여러 개의'sLLM'(작은 대형 언어 모델)이 등장했는데요. sLLM은 보통 매개변수가 60억(6B)~100억(10B)개로 기존 LLM에 비해 훨씬 작음에도 불구하고 성능은 못지 않기 때문에 저비용·고효율의 강점을 가집니다. 오픈AI의 ‘GPT-3’는 매개변수가 1750억개, 구글의 ‘LaMDA’(람다)가 1370억개, ‘PaLM’(팜)이 5400억개에 달하는 것과 비교하면 효율성을 더욱 체감할 수 있습니다.

그렇다면 2024년에 주목해야 할 최고의 오픈 소스 LLM 다섯 가지는 무엇일까요?

2024년에 주목해야 할 오픈소스 Top 5

1. Llama 2

출처: Meta AI

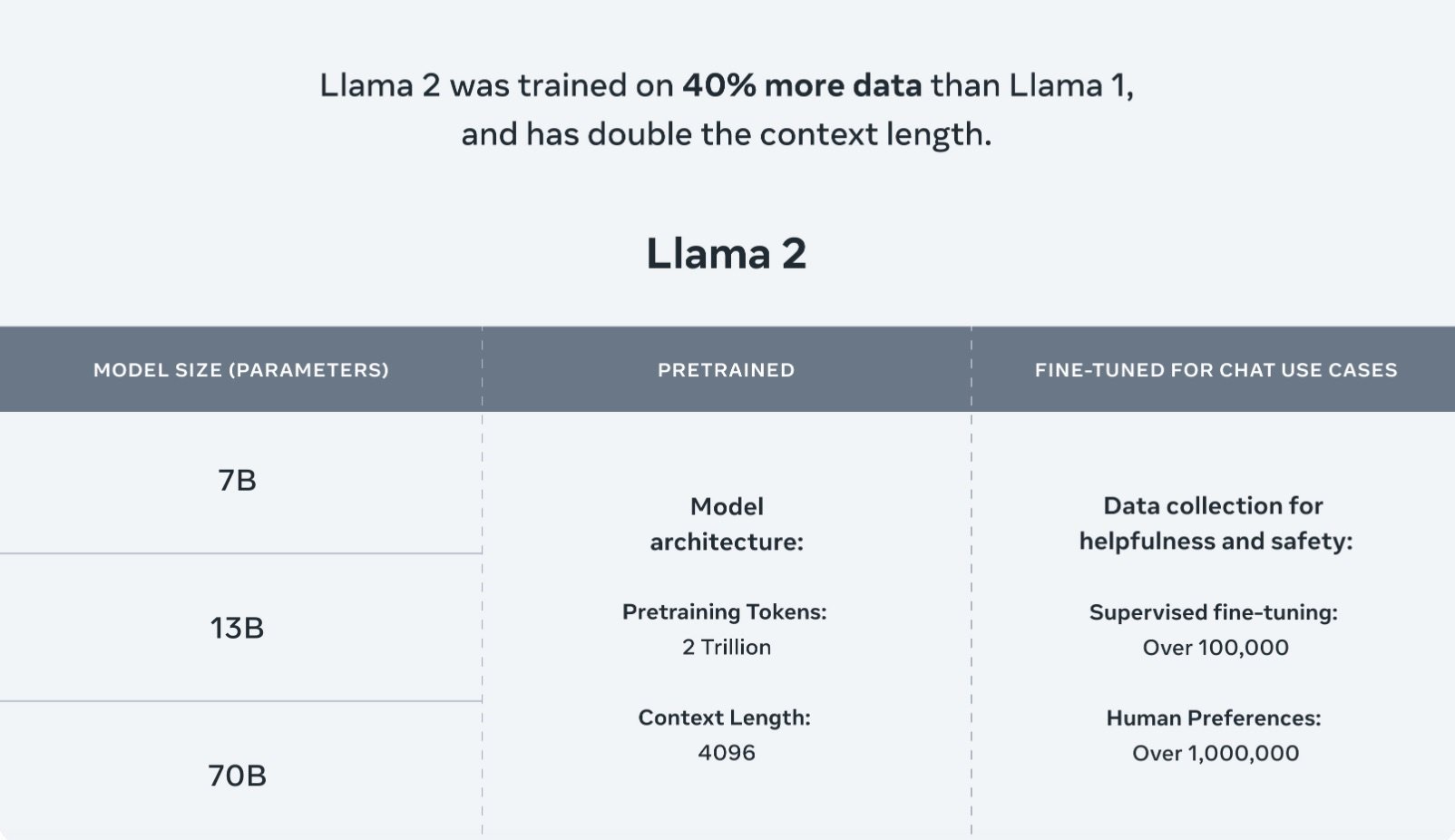

Llama 2는 메타 AI에서 개발한 오픈 소스 LLM으로, 가장 인기 있는 오픈 소스 LLM 중 하나입니다. Llama 2는 Llama의 첫 번째 상용 버전으로 2023년 7월 18일에 출시되었습니다. 7B에서 70B까지 네 가지 크기를 제공하며, Llama 2의 사전 학습 데이터는 Llama 1보다 더 큰 2조 개의 토큰으로 구성되어 있습니다.

표준 트랜스포머 아키텍처를 활용하는 Llama 2 는 RMSNorm (Root mean square layer normalization) 및 RoPE(Rotary Positional Embedding)와 같은 새로운 기능을 적용합니다. Llama 2 채팅은 supervised fine-tuning(미세 조정)으로 시작하여 RLHF(Reinforcement learning from human feedback)를 통해 개선됩니다. Llama 1과 동일한 tokenizer인 Byte Pair Encoding(BPE) 알고리즘과 SentencePiece를 사용합니다. 또한 LLM에서 중요한 문제인 진실성, 유해성 및 편향성에 대한 우려를 해소하기 위해 안전성 검사에 주의를 기울이고 있습니다. Azure와 Windows를 비롯한 다양한 플랫폼에서 미세 조정이 가능하도록 확장되어 다양한 프로젝트에 유용합니다.

인간 피드백을 통한 강화학습(RLHF)과 보상 모델링을 통해 양방향 대화에 최적화한 LLaMA 2-Chat (출처: Meta AI)

2. Mistral

Mistral-7B는 Mistral AI가 출시한 모델로 맞춤형 학습과 튜닝 및 데이터 처리 방법을 기반으로 만들어졌습니다. 이 모델은 Apache 2.0 라이선스로 제공되는 오픈 소스 모델로, 실제 애플리케이션에 적용할 수 있게 설계되어 효율적이며 높은 성능을 제공합니다. 출시 당시 평가된 모든 벤치마크에서 최고의 오픈소스 13B 모델 중 하나인 Llama 2와 비교하여 우수한 성능을 발휘하기도 했습니다. 이 모델은 수학, 코드 생성 및 추론을 포함한 다양한 벤치마크에서 뛰어난 성능을 보여줍니다.

다양한 벤치마크에서 Mistral 7B와 Llama 모델의 성능 비교 (Source: Mistral 7B)

복잡한 계산이 없는 대용량 batch 처리 작업에는 Mistral-7B와 같은 Mistral-Tiny 모델이 적합합니다. 이 모델은 애플리케이션에 가장 비용 효율적입니다. Mistral-small (Mistral 8x7B Instruct v0.1)은 영어, 프랑스어, 이탈리아어, 독일어, 스페인어 등 5개 언어를 지원하며 코드 생성에서 뛰어난 성능을 발휘합니다. Mistral-medium은 GPT-3.5를 능가하는 고성능의 프로토타입 모델을 사용하는 것으로 알려져 있습니다. 이는 고품질 애플리케이션에 적합합니다.

3. Solar

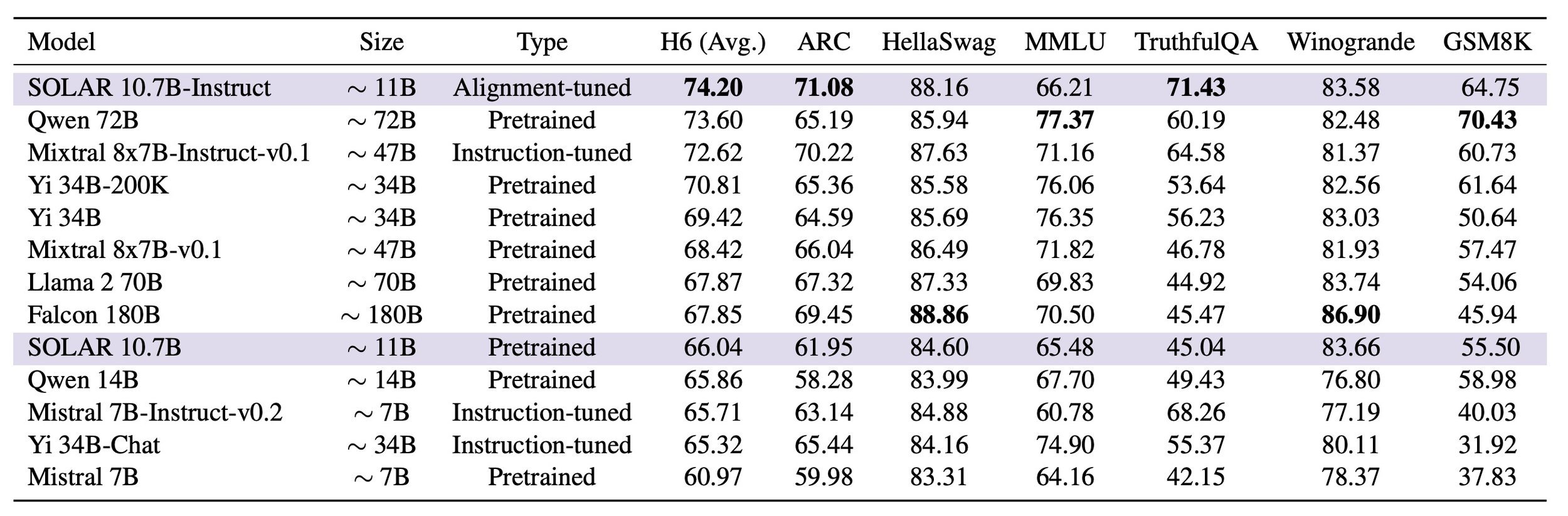

Solar(솔라)는 업스테이지에서 출시한 소형 언어모델입니다. 107억 개의 매개변수로 이루어진 솔라 10.7B는 기존의 Llama 2 및 Mistral-7B와 같은 모델보다 필수적인 NLP(자연어 처리) 작업에서 더 나은 성능을 발휘하면서도 효율성을 유지하는 최신이자 최고의 오픈소스 LLM입니다. 2023년 12월에는 세계 최대 머신러닝 플랫폼인 허깅페이스가 운영하는 '오픈 LLM 리더보드'에서 1위를 달성하기도 했는데요. 이 결과는 소형 LLM(sLM)의 기준이라고 할 수 있는 300억 매개변수(30B) 이하 사이즈로 글로벌 최고 성능 모델에 올라 더욱 의미가 깊습니다.

작은 크기로 구성된 Solar 모델의 성능을 최적화하기 위해, 업스테이지는 'Depth Up-Scaling' 방법을 사용했습니다. 이는 성능이 좋지만 큰 13B 모델과 충분히 작지만 지적 제약이 있는 7B 모델 사이의 장점을 결합하고자 최적의 모델 크기를 찾기 위한 방법으로, 업스테이지는 오픈소스의 7B 모델들을 기반으로 자체적인 Depth Up-Scaling 방식을 적용, 레이어를 추가하며 깊이를 더해 소형 모델의 성능을 극대화하였습니다. MoE(mixture-of-experts)와 달리, Depth Up-Scaling은 훈련 및 추론에 복잡한 변경을 요구하지 않습니다. 이러한 접근 덕분에 Solar는 3조 개가 넘는 토큰의 우수한 데이터를 통해 확장된 10.7B로 출시되었으며, 최적의 크기와 성능으로 조합될 수 있었습니다.

특히 Solar는 사전 학습 및 파인튜닝 단계에서 리더보드 벤치마킹 데이터 셋을 사용하지 않고, 자체적으로 구축한 데이터를 적용했습니다. 이는 리더보드 점수를 높이기 위해 벤치마크 셋을 직접 적용하는 타 모델들의 사례와 달리 Solar가 실제 업무에서 다양한 태스크에 활용하는 등 높은 사용성을 보여줄 수 있음을 나타냅니다.

SOLAR 10.7B 및 SOLAR 10.7B-Instruct와 타 언어 모델들에 대한 평가 결과 (출처: SOLAR 10.7B: Scaling Large Language Models with Simple yet Effective Depth Up-Scaling)

4. Yi

Yi-34B는 8개월 만에 10억 달러 이상의 가치를 인정받으며 유니콘 기업으로 성장한 중국 스타트업 01.AI가 개발했습니다. Yi 시리즈는 다국어 모델을 목표로 모델 학습에 고품질의 3T 다국어 말뭉치를 활용했습니다. 이는 언어 이해력, 상식 추론, 독해력 등에서 주목할만한 성능을 보였습니다. Yi 는 6B 및 34B 크기의 모델을 제공하며 추론 시간 동안 32K까지 확장할 수 있습니다.

Yi의 깃허브에 따르면 6B 시리즈 모델은 개인용 및 학술용으로 적합하고, 34B 시리즈 모델은 상업용 및 개인용, 학술용으로 적합하다고 합니다. Yi 시리즈 모델은 LLaMA와 동일한 모델 아키텍처를 사용하므로 사용자는 LLaMA의 생태계를 활용할 수 있습니다. 01.AI는 생성형 AI 시장의 선두 주자를 노리며 올해 개선된 모델을 출시하고 상용 제품을 확대할 계획입니다.

6. Falcon

Falcon은 아랍에미리트(UAE)의 기술혁신연구소에서 출시한 생성형 대규모 언어 모델입니다. 이 모델은 180B, 40B, 7.5B, 1.3B 파라미터의 AI 모델을 제공합니다. Falcon 40B는 연구자와 상업 사용자 모두에게 로열티 없이 제공되고 있습니다. 11개 언어로 작동 가능하며 특정 요구 사항에 맞게 파인튜닝(미세 조정) 할 수 있습니다. Falcon 40B는 GPT-3 및 Chinchilla AI보다 적은 훈련 컴퓨팅 리소스를 사용하며 품질 높은 훈련 데이터에 초점을 맞춥니다. 180B 모델은 1800억 개의 파라미터를 가지고 있으며 3.5조 개의 토큰을 훈련하여 탁월한 성능을 발휘합니다.

오픈소스 LLM으로 여는 AI의 미래

이제 AI 시장에서 LLM을 빼놓고는 변화와 혁신을 논하기 어려울만큼 LLM은 다양한 산업군에 적용되어 새로운 아이디어와 기술을 탄생시키고 있습니다. 때문에 누구나 참여하고, 개선하며, 학습할 수 있는 생태계를 제공하는 오픈소스 LLM은 AI의 미래를 변화시키는 혁신적인 역할을 하게 될 것입니다. 오픈소스 LLM으로 발전하는 AI 기술은 올해 우리에게 또 어떠한 놀라움을 안겨주게 될지 주목됩니다.

☀️ Solar LLM

[NEW] Upstage’s Solar 10.7B

Introducing a new 10.7B model that outperformed all competing models on the Open LLM Leaderboard.

![[보도사진]업스테이지, 사전학습 LLM Solar 공개… 글로벌LLM 대전 본격 참전.jpeg](https://images.squarespace-cdn.com/content/v1/618b246f4dfdef45045a78dd/1702508852298-V88O6QBP5TCJVZP9KMI8/%5B%EB%B3%B4%EB%8F%84%EC%82%AC%EC%A7%84%5D%EC%97%85%EC%8A%A4%ED%85%8C%EC%9D%B4%EC%A7%80%2C+%EC%82%AC%EC%A0%84%ED%95%99%EC%8A%B5+LLM+Solar+%EA%B3%B5%EA%B0%9C%E2%80%A6+%EA%B8%80%EB%A1%9C%EB%B2%8CLLM+%EB%8C%80%EC%A0%84+%EB%B3%B8%EA%B2%A9+%EC%B0%B8%EC%A0%84.jpeg)